Для специалиста по поисковой оптимизации понимание того, как Google и другие поисковые системы сканируют и индексируют веб-сайт, является одним из главных приоритетов. Однако получить необходимые данные для анализа сотен тысяч страниц не так просто, как хотелось бы.

Первое, о чем подумает опытный SEO-гуру, — это автоматическая обработка лог-файла визитов сайта, чтобы отследить посещения робота Google. Но само посещение еще не гарантирует добавление страницы в индекс. У нас сотни тысяч страниц находятся в индексе, поэтому мы задумались о разработке надежного способа получения данных о статусе индексации Google.

В этом материале мы поговорим:

-

почему важно знать статус индексации сайта;

-

какие проблемы чаще всего возникают при сборе данных об индексации Google;

-

о решении этой задачи с помощью кастомного инструмента проверки индексации;

-

как проверить индексацию сайта самостоятельно.

Почему важно знать статус индексации сайта

Если вы крупный издатель, то наверняка хотите привлечь потенциальных пользователей или клиентов на сайт из поиска Google. Если веб-сайт (или его часть) не проиндексирован, вы не будете отображаться в результатах поиска и потеряете любой потенциальный органический трафик, конверсии или рекламный инвентарь останется невостребованным.

Но может быть и обратная проблема. Если веб-сайт создает URL-адреса в геометрической прогрессии (обычная проблема на сайтах электронной торговли) или допускает неконтролируемый пользовательский контент, то Google может сканировать и индексировать больше, чем следовало бы. Это может быстро привести к огромной неэффективности в ущерб основной архитектуре сайта. В этом случае страницы, которые представляют пользу для издателя будут отдаваться сервером медленнее, именно потому что сервер тратит много времени на отработку запросов бота Google. Поэтому реальный человек, когда зайдет на сайт, получит контент медленнее или вообще не получит, так как сервер сбросит его соединение по таймауту.

Распространенные проблемы при сборе данных об индексации Google

Скорее всего, для сбора данных индексации вы используете Google Search Console или стороннее решение. Однако оба варианта имеют свой набор недостатков, когда дело доходит до проверки индексирования сотен тысяч страниц. Обычно они связаны с доступностью данных и точностью результатов. Это те проблемы, с которыми столкнулись мы.

Ограничения Google Search Console

Google Search Console (GSC) — достоверный и точный источник данных о статусе индексации, ведь он подключен к системе индексирования Google. В GSC есть три суперполезных отчета, которые предоставляют данные о статусе индексации: инструмент URL Inspector, отчет о покрытии и отчет о файлах Sitemap.

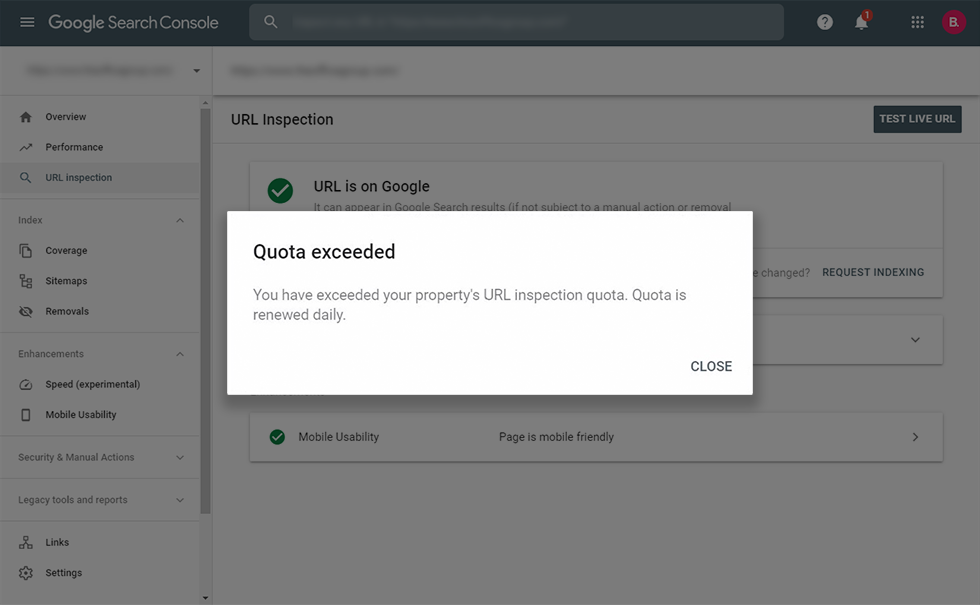

Однако ни один из этих отчетов не подходит для крупномасштабных веб-сайтов, поскольку GSC ограничивает количество URL-адресов, которые вы можете проверять в день (50 URL для инспектора, и по 1000 URL в остальных отчетах).

Мы хорошо знаем об этом, потому что нам приходилось автоматизировать работу браузера для работы с URL Inspector Tool. Возможно, мы поделимся этим драгоценным опытом в новой статье.

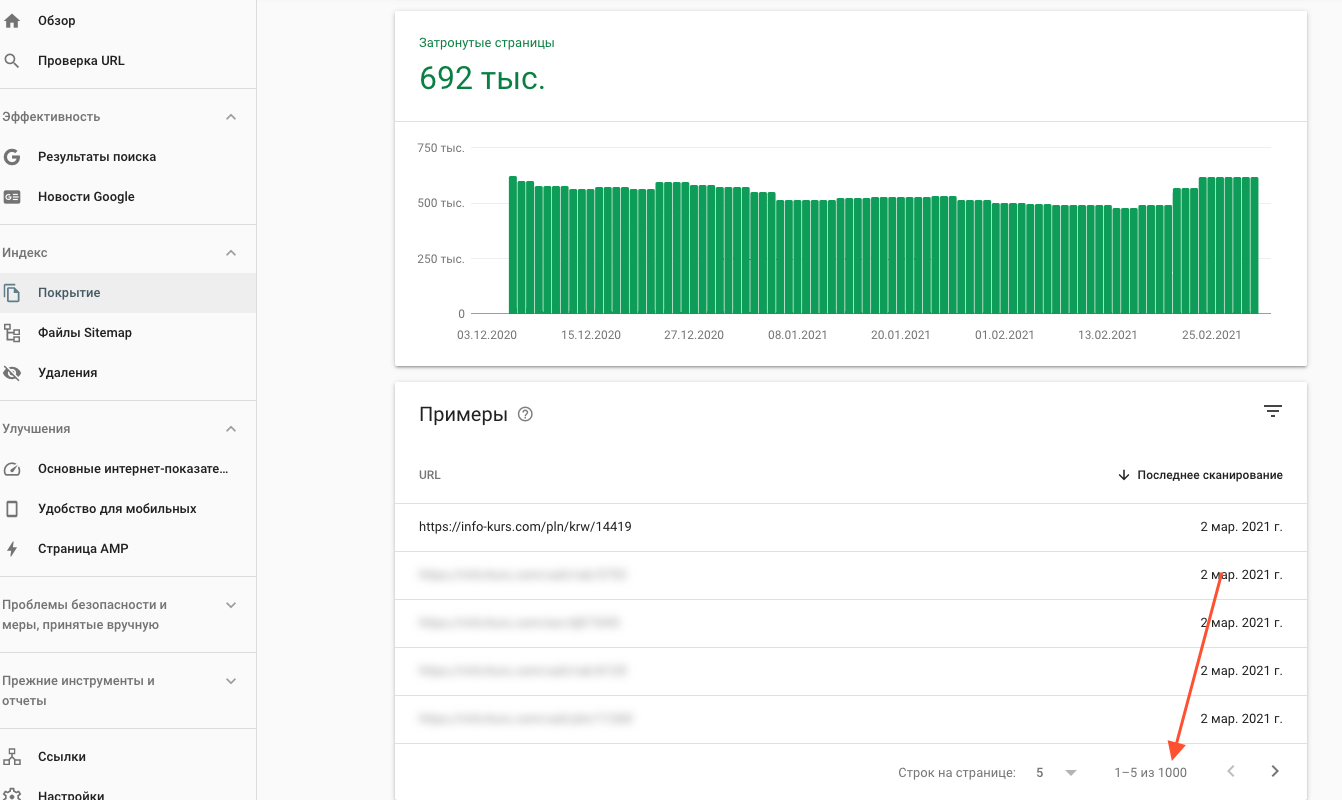

Теоретически отчет о покрытии и отчет о файлах Sitemap могут помочь, но, к сожалению, Google Search Console ограничивает отчет об экспорте до 1000 строк данных, и сейчас нет доступа к API для извлечения большего количества.

GSC ограничивает экспорт до 1000 URL, но у нас сотни тысяч страниц… Спасибо Google 🙂

Наверное, единственный способ обойти это ограничение — разделить всю архитектуру сайта на XML-карты объемом не более 1000 URL-адресов. Следовательно, если на сайте есть 100 000 (известных / важных) URL-адресов, потребуется создать 100 XML-файлов Sitemap. Но этим было бы очень сложно управлять, и поэтому не вариант.

Кроме того, это не даст вам необходимых данных для индексации неконтролируемых URL-адресов, созданных с помощью фасетной навигации или пользовательского контента.

Ограничения URL Profiler

В некоторых случаях профилировщик URL был подходящим вариантом для сбора данных индексации. Хотя нам нравится этот инструмент для решения других задач, мы поняли, что у него много проблем с получением точных данных для «нечистых» URL.

Некоторые примеры включают параметризованные URL-адреса, URL-адреса с закодированными символами, URL-адреса с различным регистром букв и URL-адреса с небезопасными символами.

Решение: кастомный инструмент проверки индексации

Чтобы обойти ограничения, с которыми сталкиваются большинство SEO-специалистов, работающих с крупными проектами, мы разработали специальный скрипт для проверки индексации.

Он может проверять неограниченное количество URL-адресов с любыми типами проблемных символов: параметры, кодировка, зарезервированные символы, небезопасные символы, разные алфавиты — если Google проиндексировал страницу, наш скрипт подтвердит это.

Как настроить скрипт

Вам понадобятся начальные знания о командной строке и немного о node.js. Скорее всего, этого будет достаточно.

Сначала установите последнюю версию Node.js на свой компьютер. Затем загрузите или клонируйте наш репозиторий с GitHub.

Откройте командную строку и перейдите в папку, которую вы только что скачали. Затем установите необходимые зависимости, используя следующую команду:

npm install

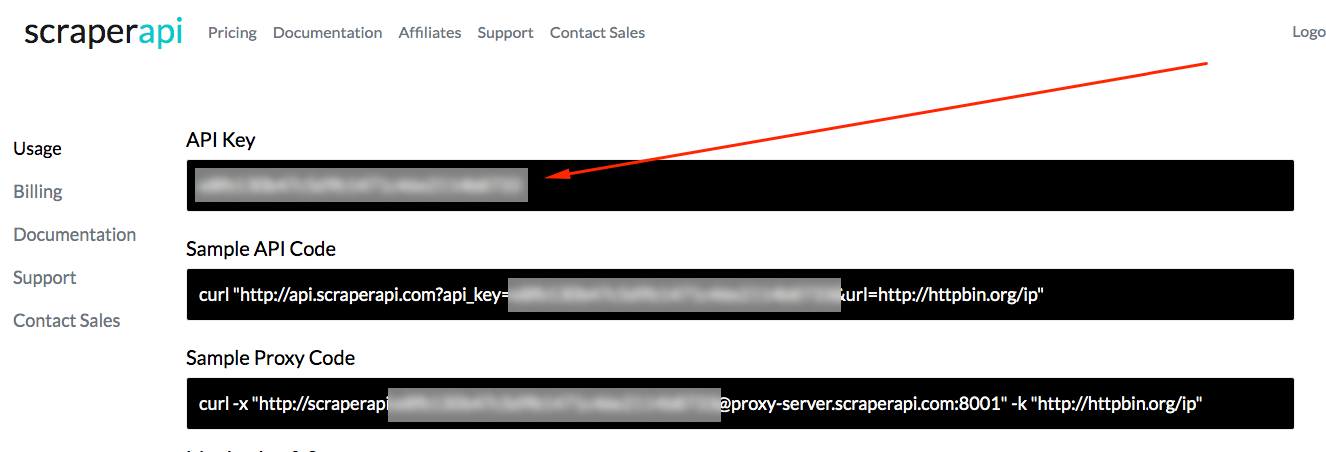

Раньше, если бы вам приходилось парсить результаты поиска Google, понадобилось бы много прокси-серверов, но благодаря ребятам из ScraperAPI это больше не проблема. У них есть тысячи прокси по всему миру, поэтому всё, что вам нужно сделать, — это отправить запрос, используя вызов через их API, они будут выполнять ротацию прокси в фоновом режиме. Как это сделать, читайте дальше.

Перейдите на сайт ScraperAPI и создайте учетную запись. Первые 1000 запросов в месяц бесплатны, этого более чем достаточно для тестирования нашего скрипта, а за $29 можно проверить 250 000 страниц.

Зайдите в свой аккаунт и получите свой API-ключ.

Добавьте свой ключ API в файл APIKEY.js, который находится в папке, которую вы скачали с нашего репозитория.

Пора запускать скрипт

Теперь добавьте список URL-адресов, которые вы хотите проверить на индексирование Google и сохраните его без заголовков в виде CSV с именем urls.csv в папке, которую скачали. Обязательно используйте полные URL-адреса с протоколом.

Если у вас нет списка, вы можете использовать наш список сложных URL. Мы подготовили его, когда разрабатывали скрипт, и он включает почти все проблемные типы URL-адресов, а также несколько поддельных URL-адресов, чтобы проверить, не было ли ложных срабатываний.

Перейдите в обратно в командную строку и запустите скрипт с помощью следующей команды:

npm run start

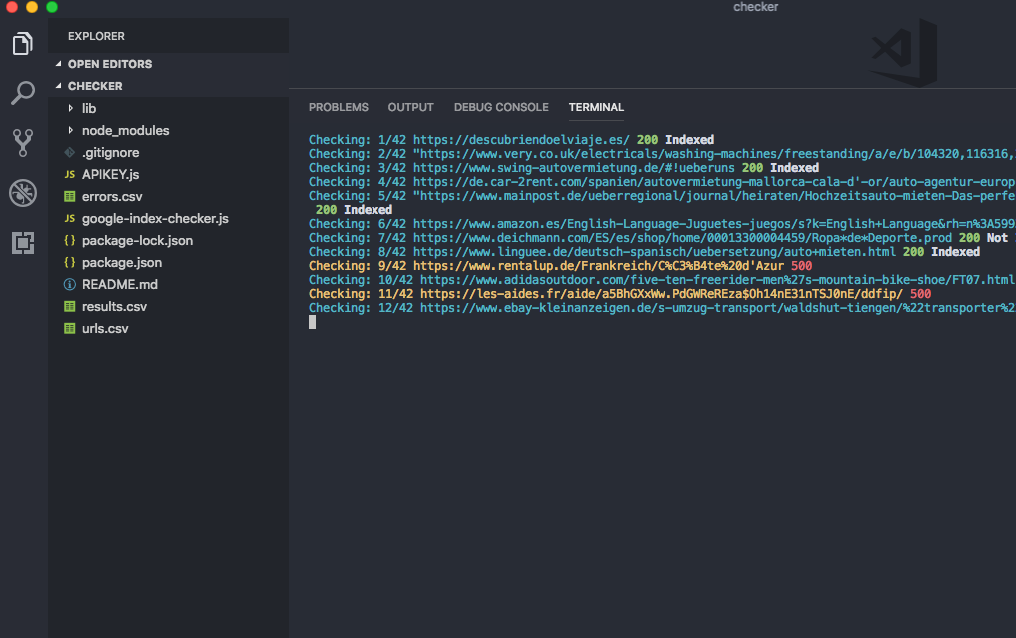

Работа скрипта началась. Теперь вы должны увидеть URL-адреса из вашего CSV, появляющиеся в командной строке с кодом ответа сервера.

Поскольку скрипт использует прокси, иногда вы будете получать код состояния 500. Ничего страшного:, скрипт повторно обработает эти ошибки и повторно запустит список, пока не будут проверены все URL-адреса.

По завершении сценария вы получите сообщение об успешном выполнении и новый файл с именем results.csv. Внутри вы найдете список URL-адресов с указанием статуса индексации.

В среднем проверка 2500 URL-адресов занимает около часа, поэтому если вы планируете использовать этот скрипт для тысяч URL-адресов, имейте это в виду.